Entenda como funciona o web scraping, ou raspagem de dados, tecnologia aplicada negócios por meio de análises de dados internos ou setoriais

O que você lerá neste artigo

- O que é o web scraping e como funciona?

- O web scraping é uma prática ilegal?

- Quais as principais aplicações da raspagem de dados?

- Quais são os tipos de raspagem de dados?

- Web Scraping e API: qual a diferença?

- O conceito data-driven e a tomada de decisões baseadas em dados

O que é o web scraping e como funciona?

O Web scraping, ou “raspagem de dados”, é uma ferramenta muito utilizada em estratégias de transformação digital e também para automatizar processos de coleta e consulta de dados e informações públicas, para diversos fins.

Vamos começar entendendo os objetivos desta tecnologia.

Em primeiro lugar, o objetivo principal de analisar outras páginas na internet e colher dados é garantir a fidelidade e integridade da informação que foi coletada. Isto reafirma como a transformação digital está invadindo as empresas, tornando o espaço para trabalhos manuais e repetitivos cada vez mais distante.

No geral, a tecnologia vem ganhando cada vez maior notoriedade, já que elimina a intervenção humana, utilizando scripts e robôs programados para copiar dados em larga escala.

No entanto, não é à toa que a procura por especialistas certificados nestas ferramentas seja em T.I., Data Analytics, Master Data Management, Data Science – até Economia e áreas similares – aumentou agressivamente nos últimos anos.

Estes profissionais têm a missão de encontrar dados relevantes, filtrá-los, reuni-los em uma visão única para fazer análises que apoiem a tomada de decisão.

O web scraping é uma prática ilegal?

Não. Coletar dados públicos e acessíveis a qualquer internauta não é considerado ilegal. Sendo assim, a automação da coleta de dados em larga escala utilizando inteligência artificial também não infringe a lei.

No entanto, principalmente após a LGPD, a coleta e a transação com dados pessoais fica restrita à autorização prévia do titular de dados.

Por exemplo, redes sociais como Facebook, Instagram, TikTok, consideram a coleta e cópia automatizada de dados armazenados como uma violação às regras de uso de seus serviços.

Mesmo assim, há muitos que copiam dados com intenções maliciosas, como coletar informações sem autorização para uso indevido. Prova disso é o aumento considerável de ciberataques e vazamentos de dados registrados nos últimos anos.

Veja também sobre Vazamentos de dados: como sua empresa pode prevenir fraudes com CPFs expostos

Ou seja, se sua empresa está considerando a busca de um aliado para esta operação, um dos pilares mais importantes é validar a confiabilidade e idoneidade da empresa operadora de dados que executará o web scraping.

Quais as principais aplicações da raspagem de dados?

A principal aplicação da raspagem de dados é coletar informações públicas em grande quantidade de forma automática, preferencialmente a consulta de dados a bases do governo.

Porém, existem diversos fins a que se aplica esta análise. Nesse contexto, existem diversas aplicações que evidenciam como funciona o web scraping e porque vale a pena a adoção desta prática no dia a dia da sua empresa, sendo:

1. Transformar dados em informação inteligente para gerar insights de negócio

Coletar e reunir dados via web scraping de diversas fontes públicas ou privadas sobre concorrentes e de um setor como um todo favorece o negócio em diversas frentes.

O gestor garante uma visão ampla e obtém referenciais comparativos, além de conhecer mais sobre seus parceiros comerciais, tudo em larga escala e utilizando o menor tempo possível.

Por exemplo, em estudo realizado pela Netrin, comprovou-se que ao menos 5% dos mais de 4 milhões de CNPJs checados mensalmente estão com irregularidades no Sintegra. Esta informação se torna útil para muitas empresas, que passam a rever seus processos de análise de risco reputacional e diligência de fornecedores, principalmente agora com a difusão de práticas de governança como um dos pilares ESG para a conquista de novos investidores.

Além deste tipo de informação, existem dados que podem gerar insights para outras frentes, como geolocalização de concorrentes para colaborar na estratégia comercial, dados de produtos diversos, entre outras possibilidades.

2. Esclarecer dúvidas de forma acelerada e precisa

O web scraping também responde e esclarece dúvidas seja sobre um mercado ou negócio, seja para corroborar uma hipótese ou derrubar um mito. Ao obter um determinado volume de dados, simplifica-se essa tarefa, permitindo a avaliação de dados de forma precisa.

Por exemplo, você está analisando dados setoriais da relação entre investimentos em tecnologia e lucros, o uso de dados do Imposto de Renda Pessoa Jurídica e do aporte de recursos na área de inovação pode trazer uma resposta muito clara para a sua dúvida.

3. Monitorar dados de mercado

Ao acompanhar dados setoriais e de concorrentes de fontes precisas coletando-as de forma rápida e automatizada, o monitoramento torna-se mais simples e rotineiro. Há inúmeros meios de se fazer isso e um dos aspectos primordiais é escolher fontes confiáveis e reconhecidas para se tirar conclusões relacionadas às políticas de preços adotadas pelo seu negócio, por exemplo.

4. Qualificar a prospecção de novos clientes (B2B)

A coleta de dados de fontes públicas é utilizada para fins de prospecção qualificada para o seu negócio. Inclusive, é importante ressaltar que a LGPD não se aplica a dados de pessoas jurídicas, somente pessoas físicas. No entanto, em uma prospecção, a recomendação é agir de boa-fé para não gerar conflitos.

Uma boa maneira de iniciar uma prospecção é segmentar informações por área de atuação, localização, faturamento, entre outros critérios usados para se determinar potenciais clientes.

5. Avaliar a reputação da marca ou de um produto

O monitoramento de alguns sites específicos pode dar indícios sobre a reputação da marca no meio online. Além disso, é também um excelente caminho para identificar o que está sendo falado sobre um produto ou como a marca é avaliada pelos consumidores.

Veja também: Valorize a reputação empresarial com compliance

Quais são os tipos de raspagem de dados?

Conhecer os diferentes tipos de raspagens de dados é fundamental para definição de estratégias de automação e RPA (Automação Robótica de Processos). Veja quais os tipos de raspagens e suas vantagens:

Crawler x Scraper

De forma simples, a extração de dados possui dois princípios básicos. Em ambos os casos, existem soluções difundidas no mercado.

O crawler é um robô que varre conteúdos e dados na internet, sendo programado para diferentes fins. Não à toa, o termo significa “rastejar” em inglês, indicando que um especialista está procurando informações através do rastreio de dados.

Já o scraper é o robô que extrai dados de uma página ou sistema específico, como aponta a tradução do termo para português: “raspador”. Em geral, essas soluções podem ter diferentes níveis de complexidade, de acordo com a necessidade de cada projeto.

Raspagem de dados manual x automática

É possível fazer o trabalho de scraping “na unha”, é claro, coletando informações e agrupando em uma planilha ou sistema para realizar a análise. No entanto, esta tarefa pode ser árdua, repetitiva e demorada, além de perigosa.

Obviamente, é mais comum contratar robôs capazes de fazer a varredura das informações e compilá-los em um único sistema. T odo este recolhimento de dados também recebe o nome de web data extraction ou data scraping.

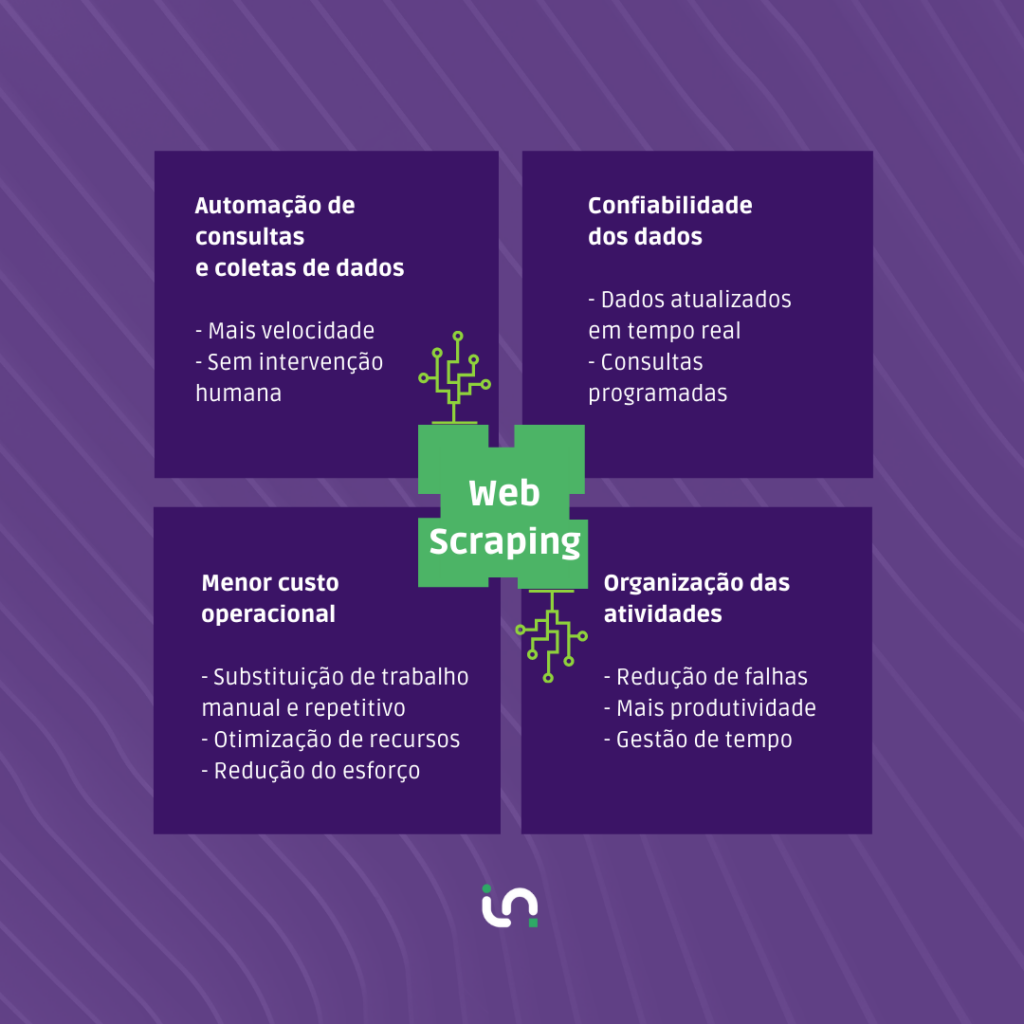

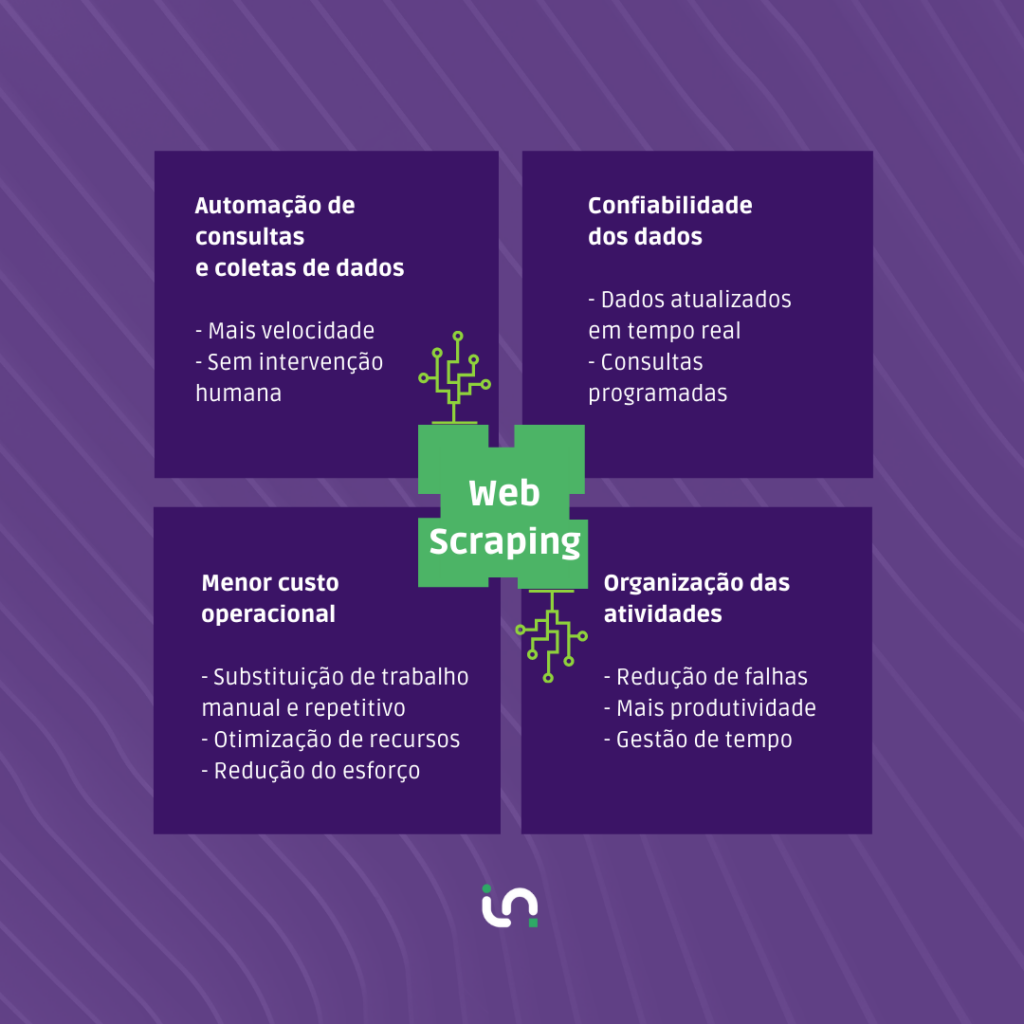

A coleta de dados automática possui vantagens para diversas áreas de apoio. Abaixo, listamos quatro principais vantagens do web scraping para negócios:

- Automação de consultas e coletas de informações cadastrais: benefício para todas as áreas de negócio, que constantemente buscam por estas informações no seu dia a dia.

- Dados confiáveis e atualizados: a chance de a informação coletada estar correta é muito maior se for coletada por um robô.

- Redução do custo operacional: substituição de trabalho manual e repetitivo, otimização de recursos da empresa e processos.

- Organização das atividades: a realocação de pessoas em tarefas mais inteligentes e desafiadoras, além da melhoria na gestão do tempo

Web Scraping e API: qual a diferença?

A raspagem de dados e as APIs (Application Programming Interface) não são a mesma coisa, porém, têm o mesmo objetivo: acessar os dados!

São tecnologias que, juntas, transacionam os dados, fornecendo-os em uma interface como um ERP ou qualquer outro sistema. Ou seja, enquanto a raspagem da Web extrai os dados de qualquer site através do uso de software de raspagem, as APIs dão acesso direto aos dados desejados.

O conceito data-driven e a tomada de decisões baseadas em dados

A tomada de decisões das empresas está cada vez mais orientada por dados, insights e geração de inteligência a partir de informações que podem parecer desconexas. Nem todo dado importante para o seu negócio estará sob seus domínios, por isso a importância da tecnologia para suportar e transacionar tantos dados.

Para exemplificar melhor, imagine entrar em uma base de dados pública para fazer uma prospecção qualificada de clientes. Isso é possível e permite ao negócio usar essas informações para identificar o tamanho do seu mercado e o perfil de potenciais clientes, o que abre a perspectiva de planejar uma abordagem comercial cada vez mais assertiva.

Na mesma lógica, é possível aplicar a automação de coleta de dados em sindicatos ou associações setoriais, que costumam contar com inúmeras informações a respeito de um segmento. O exemplo foi o da prospecção qualificada, mas a estratégia é viável também para avaliar concorrentes, validar hipóteses, analisar o tráfego de um site ou blog, em prol desenvolver novas ideias para o seu negócio, mapear setores ou concorrentes.