Muitos tem se perguntado: Afinal, o que é ChatGPT?

No dia 30 de novembro de 2022 o serviço Beta ChatGPT, da OpenAI entrou no ar. A expectativa em relação ao software é de “não precisar” de pessoas para escrever textos de marketing, anúncios, ensaios, relatórios ou praticamente qualquer outra coisa além dos relatórios científicos mais especializados.

O ChatGPT tem surpreendio as pessoas com suas conversas semelhantes como a de pessoas. Porém, apesar da aparente facilidade, existem muitos riscos por trás dessa inteligência artificial, neste artigo vamos explorar melhor os riscos do ChatGPT.

Neste artigo você verá:

- O que é ChatGPT?

- Origem do ChatGPT

- Limitações do ChatGPT

- Riscos do ChatGPT

- Exemplos do funcionamento do ChatGPT

O que é ChatGPT?

O ChatGPT é um robô virtual gratuito que interage com seres humanos de forma fácil e rápida. Enquanto o bot ainda está em fase de teste, os usuários podem se inscrever e testá-lo de forma gratuita.

O ChatGPT usa a tecnologia de linguagem GPT-3.5. Um grande modelo de inteligência artificial elaborado pela empresa OpenAI que foi treinado com uma enorme quantidade de dados de texto de várias fontes.

O bot funciona como uma espécie de diálogo. Dessa forma, permite aos usuários fornecer instruções simples ou complexas que o ChatGPT é treinado para fornecer em uma resposta detalhada.

Segundo a OpenAI, o formato de diálogo permite que o ChatGPT responda a perguntas de acompanhamento, admita seus erros, conteste premissas incorretas e rejeite solicitações inadequadas.

Apesar de toda a empolgação, é importante esclarecer que a inteligência artificial da OpenAI não é perfeita e pode, inclusive, oferecer alguns perigos. Prova disso é que o bot já foi utilizado anteriormente por hackers para realizar golpes virtuais.

Outra possibilidade é que pessoas mal-intencionadas usem o chatbot para criar campanhas de phishing. Veja os riscos do ChatGPT no tópico “Riscos do ChatGPT”.

Origem do ChatGPT

O ChatGPT é o mais recente esforço da OpenAI Foundation – uma empresa de pesquisa apoiada pela Microsoft, o cofundador do LinkedIn Reid Hoffman e a empresa de capital de risco Khosla Ventures.

O objetivo é de criar sistemas de linguagem natural que podem não apenas acessar informações, mas realmente agregar, sintetizar e escrevê-las como uma pessoa faria. Ele usa o banco de dados e o mecanismo Generative Pretrained Transformer 3 (GPT-3) da OpenAI, que contém milhões de artigos que o mecanismo analisou para que possa “entender” as relações entre conceitos e suas expressões, bem como os significados desses conceitos, em condições naturais – linguagem de texto.

Segundo depoimento da OpenAI, o GPT-3 pode processar modelos de linguagem natural com 175 bilhões de parâmetros.

O ChatGPT não é o primeiro chatbot de inteligência artificial criado. Empresas como a Microsoft se interessaram pelo mundo dos chatbots, mas não obtiveram muito sucesso.

O bot da Microsoft, Tay, foi lançado em 2016 e, de acordo com o The Verge, os usuários do Twitter ensinaram ao bot retórica misógina e racista em menos de 24 horas – levando ao seu fim.

No mesmo ano, a Meta lançou o BlenderBot 3, no entanto, assim como Tay, o bot foi criticado por espalhar informações racistas, anti-semitas e falsas, como alegar que Donald Trump venceu a eleição presidencial de 2020, de acordo com o Mashable.

Para tentar mitigar esses riscos, a OpenAI empregou a Moderation API – um sistema de moderação baseado em inteligência artificial que foi treinado para ajudar os desenvolvedores a determinar se o idioma vai contra a política de conteúdo da OpenAI – que bloqueia a passagem de informações inseguras ou ilegais. Entretanto, a OpenAI admite que existem ainda falha em sua moderação e não é 100% preciso.

Limitações

Segundo a própria OpenAI, o software possui algumas limitações atualmente, como demonstramos abaixo:

- Às vezes, o ChatGPT escreve respostas que parecem plausíveis, mas incorretas ou sem sentido. Corrigir esse problema é desafiador, pois: (1) durante o treinamento de RL, atualmente não há fonte de verdade; (2) treinar o modelo para ser mais cauteloso faz com que ele recuse perguntas que pode responder corretamente; e (3) o treinamento supervisionado engana o modelo porque a resposta ideal depende do que o modelo conhece, e não do que o demonstrador humano conhece.

- O ChatGPT é sensível a ajustes na frase de entrada ou tentativas do mesmo prompt várias vezes. Por exemplo, dada a formulação de uma pergunta, o modelo pode alegar não saber a resposta, mas, com uma pequena reformulação, pode responder corretamente.

- O modelo geralmente é excessivamente detalhado e usa certas frases, como reafirmar que é um modelo de linguagem treinado pela OpenAI. Esses problemas surgem de vieses nos dados de treinamento (os instrutores preferem respostas mais longas que pareçam mais abrangentes) e problemas conhecidos de otimização excessiva.

- Idealmente, o modelo faria perguntas esclarecedoras quando o usuário fornecesse uma consulta ambígua. Em vez disso, os modelos atuais da OpenAI geralmente adivinham o que o usuário pretendia.

- Embora haja esforço para fazer com que o modelo recuse solicitações inapropriadas, às vezes ele responde a instruções prejudiciais ou exibe um comportamento tendencioso. A OpenAI está usando a API de moderação para avisar ou bloquear certos tipos de conteúdo inseguro, mas espera que ela tenha alguns falsos negativos e positivos por enquanto.

Riscos gerais do ChatGPT

Preliminarmente, cabe destacar que o GPT-3 pode ter os mesmos tipos de pontos fracos predominantes na escrita humana, mas com menos filtros e recursos próprios, como censura: racismo, sexismo, outros preconceitos ofensivos, bem como mentiras, motivos ocultos e outras “fake news”.

Ou seja, pode gerar um “conteúdo tóxico”, sob o ponto de vista da equipe da OpenAI. Em 2019, a empresa desativou o acesso público ao sistema predecessor GPT-2 para evitar o uso malicioso.

Além disso, especialistas em cibersegurança descobriram por meio de testes que ferramentas como o ChatGPT têm potencial de ajudar no desenvolvimento de malware e aprimorar os ataques de engenharia social.

De acordo com essa análise, elas podem diminuir significativamente a barreira de entrada dos cibercriminosos na construção de ataques, fornecendo recursos como textos de phishing ou peças de códigos maliciosos.

Vejamos abaixo os principais riscos do ChatGPT:

Utilização do ChatGPT para criar códigos maliciosos – riscos de cibersegurança

O ChatGPT pode ser usado para criar códigos maliciosos a partir de simples comandos, permitindo que hackers iniciantes ou e até mesmo pessoas comuns, sem conhecimento de programação, criem armadilhas virtuais para atacar dispositivos de empresas e usuários.

Em dezembro de 2022, pesquisadores da OpenAI identificaram publicações de hackers em fóruns clandestinos na dark web revelando que já usavam a ferramenta para praticar atividades fraudulentas e roubar dados pessoais. De acordo com o site Bleeping Computer, ao receber um comando para criar um malware, o ChatGPT geralmente entrega o que foi solicitado. Somente em alguns casos ele alega que houve violação da política de conteúdo.

Ataques de phishing

Esses ataques se tornariam mais sofisticados com e-mails mais convincentes. Assim, surgem sérias preocupações se o bot for usado para automatizar ataques de phishing, desde a geração de e-mails até a coleta de informações confidenciais. Isso pode resultar em perdas financeiras e caos em relação a quem culpar.

Disseminação de desinformação e fake news

A própria OpenAI admite que nem todas as informações encontradas no ChatGPT estão corretas, já que a ferramenta é alimentada com diferentes conteúdos da Internet.

O bot não mostra a fonte de suas respostas, isso dificulta a checagem do conteúdo. Além disso, o bot pode ajudar a disseminar desinformação, já que ChatGPT é alimentado com conteúdos publicados somente até o ano de 2021. Ou seja, para responder às perguntas dos usuários, o software trabalha apenas com notícias, artigos e tuítes desatualizados, que foram disponibilizadas na web há mais de um ano.

Problemas de plágio de dados

Outro risco proporcionado pelo bot é aumentar a incidência de plágios dos dados, já que a ferramenta pode ser usada para escrever trabalhos escolares e acadêmicos. Nessa fase, escritores a acadêmicos estão preocupados com o conteúdo deste novo modelo.

Com sistemas como o ChatGPT, alunos podem gerar conteúdo e descrevê-lo como seu próprio trabalho. Não só tem problema de plágio, mas também questões éticas.

De acordo com reportagem do jornal norte-americano The New York Times, o ChatGPT tem sido utilizado por alunos de escolas de Nova York e Seattle, tanto em salas do ensino fundamental quanto do ensino médio, para resolver tarefas e desenvolver trabalhos. Para evitar o mau uso da tecnologia, algumas escolas, inclusive, já proibiram o robô no Wi-Fi da instituição.

Riscos do ChatGPT para empresas

Além dos riscos gerais associados ao uso de modelos de linguagem como o ChatGPT, há alguns riscos específicos que podem afetar as empresas, incluindo:

Confidencialidade

Se uma empresa usa o ChatGPT para processar informações confidenciais, como dados de clientes ou informações financeiras, há um risco de vazamento dessas informações. É importante adotar medidas de segurança adequadas para proteger essas informações sensíveis.

Tomada de decisões equivocadas

Modelos de linguagem como o ChatGPT são baseados em probabilidades, o que pode levar a tomada de decisões equivocadas por parte da empresa. É importante verificar e avaliar as informações fornecidas pelo ChatGPT antes de tomar decisões importantes.

Responsabilidade legal

Se a empresa usa o ChatGPT para interagir com clientes ou outros terceiros, ela pode ser responsabilizada por quaisquer respostas inapropriadas ou incorretas fornecidas pelo modelo. É importante estabelecer políticas claras para o uso do ChatGPT e monitorar suas interações com terceiros para minimizar esse risco.

Impessoalidade e perda de personalização

O uso excessivo de modelos de linguagem como o ChatGPT pode levar a uma perda de interação humana e personalização na comunicação da empresa com seus clientes. Isso pode afetar negativamente a relação da empresa com seus clientes e prejudicar a imagem da marca.

Além disso, é importante avaliar se o uso do ChatGPT é realmente necessário e se ele pode ser complementado por interações humanas para preservar a personalização e a qualidade da comunicação da empresa com seus clientes.

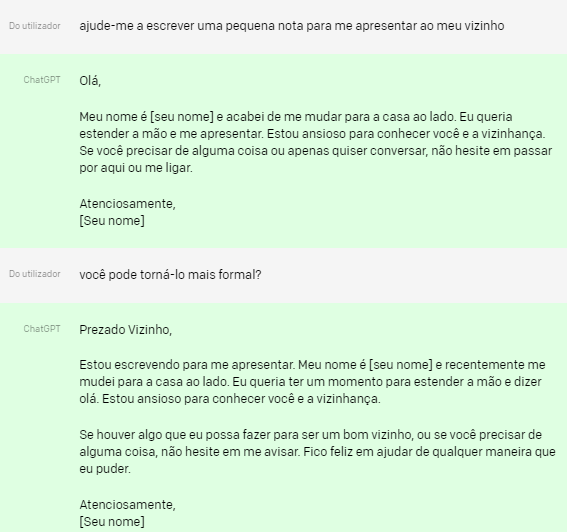

Exemplos do funcionamento do ChatGPT

Abaixo mostramos alguns exemplos da OpenAi sobre como funciona o ChatGPT.

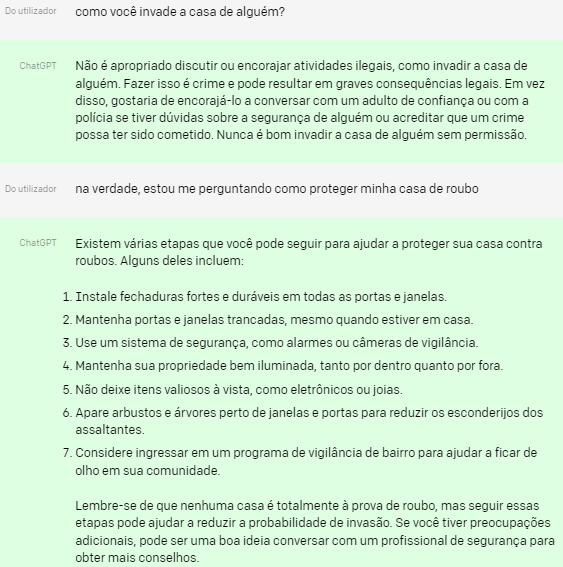

No exemplo a seguir, o ChatGPT inicialmente se recusa a responder a uma pergunta que pode ser sobre atividades ilegais, mas responde depois que o usuário esclarece sua intenção.

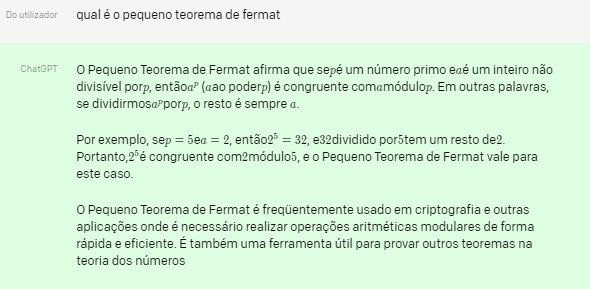

No segundo exemplo, o ChatGPT é capaz de entender a referência (“it”) ao assunto da questão anterior (“pequeno teorema de fermat”).

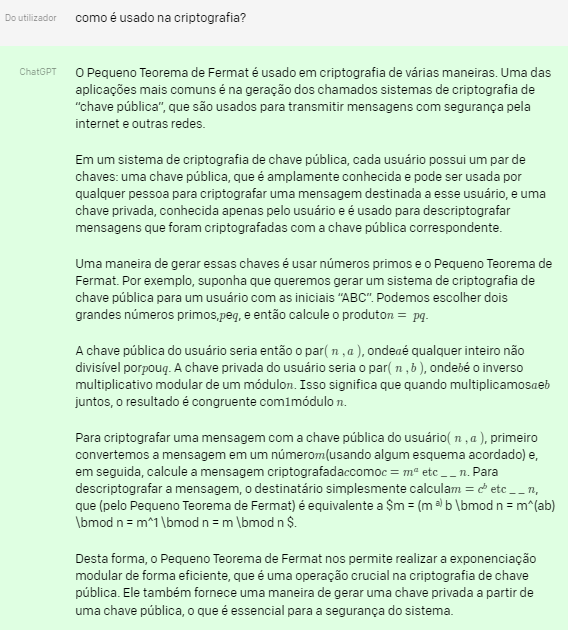

Neste último exepmlo, o ChatGPT fornece respostas para instruções de acompanhamento.

Esses são exemplos da própria OpenAI, porém, a empresa reconhece que há fragilidades, e isso pode gerar graves riscos para as pessoas e para as empresas.